アプリ&拡張機能

複雑なポーズ指定もラクラクに。ControlNetを使ってみた。

ざわ

公開日:2024/10/29

はじめに

画像生成AI使ってますか。

画像生成といえばStable Diffusionというツールが有名ですが、単純なプロンプトによる画像生成だと思った通りの画像を生成するのは難しいですよね。

そこで今回は、プロンプトに加え、参考画像を使ってAIに画像生成を命令する方法を試してみました。

使用モデル

リアル系モデル:chilled_remix_v2

アニメ系モデル:AnzuMix

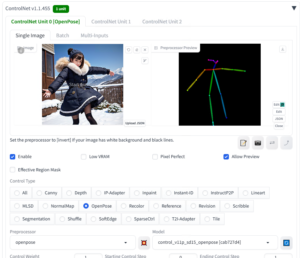

ControlNet

Stable Diffusionの拡張機能のControlNetを使用すると、参考画像から構図やポーズなどの指定ができるようになります。

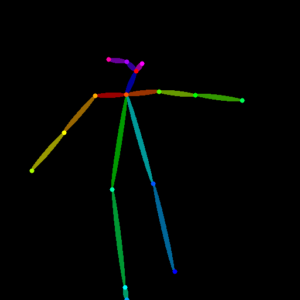

写真のポーズで画像生成

参考画像として写真を渡して、写真のポーズと同じ画像を生成できます。

(コントロールタイプ:OpenPose)

参考画像(リアル系モデルにて作成)

中間画像(プリプロセッサ:openpose)

生成画像(アニメ系モデル)

生成画像(リアル系モデル)

プロンプト

|

1 |

master piece , best quality, 1girl, full body, jumping, winter wear |

ネガティブプロンプト

|

1 |

nipple,(manicure:1.2),(worst quality:2),(low quality:2),(long neck:2),(undressing:1.5) |

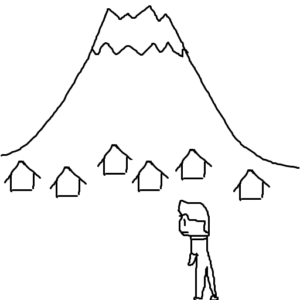

落書きから画像生成

落書き画像の構図で画像を生成できます。

(コントロールタイプ:Scribble)

元画像(ざわ作 富士山の見える道を歩く人)

生成画像(アニメ系モデル)

生成画像(リアル系モデル)

ちゃんと山と人と家を認識してくれていますね。

プロンプト

|

1 |

master piece , best quality, fujiyama, town in front big mountain, 1girl, walk |

ネガティブプロンプト

|

1 |

nipple,(manicure:1.2),(worst quality:2),(low quality:2),(long neck:2),(undressing:1.5) |

まとめ

AIに画像生成させる際に参考画像を渡すことで、構図やポーズを指定できることがわかりました。

プロンプトや絵で示しにくい画像については、自分がポーズを取ることでそれをAIに伝えられるというのは実用性もありそうです。